Компания Intel анонсировала новые процессоры Xeon Scalable Family и сразу вслед за этим HPE представила линейку серверов Gen10. Но Xeon Scalable стал не единственной новинкой в серверах, среди которых стоит отметить улучшение управляемости аппаратной инфраструктуры (переход на управление через REST API, интеграцию с различными средствами автоматизации, поддержку шаблонов и сценариев), новые модели потребления IT -ресурсов (например, финансовые услуги и оплата по мере использования), а также кардинальное улучшение системы защиты от угроз в информационной безопасности, связанных с уязвимостью низкоуровневых компонентов серверов (BIOS и прошивок).

Теперь обо всем этом по порядку.

Процессоры

Повышение производительности сервера достигается в числе прочих с помощью собственных технологий HPE под общим названием Intelligent System Tuning:

— Workload Matching (настройка под задачу) – это набор пред настроек сервера под различные конкретные задачи, которые в каждом случае повышают отдачу за счет тонких изменений конфигурации памяти, процессоров, питания, дисковой подсистемы и т.д. (всего существует около 30 регулируемых настроек, поэтому настроить сервер под конкретную задачу самостоятельно может быть непросто)

— Jitter Smoothing (сглаживание дрожания). С включением этой технологии, сервер начинает отслеживать «дрожание» частоты процессора в режиме TurboBoost, и сглаживать перепады частоты для устранения задержек обращения к разным уровням памяти, которые возникают при резком изменении частоты. В результате, в требовательных к частоте и задержкам задачах (например, ОС реального времени и некоторые Java-приложения) мы получаем прирост производительности даже сверх обычного прироста в турбо-режиме.

— Core Boosting (ускорение ядер). Эта технология станет доступной в серверах Gen10 в ближайших релизах (осень 2017 – весна 2018), для некоторых процессоров Intel Xeon Scalable семейств 6000 и 8000. Она предназначена для повышения частоты активных ядер в процессорах Intel Xeon в режиме TurboBoost сверх «обычной» доступной частоты в этом режиме. В результате таких настроек можно оставаться на том же уровне производительности, например, в БД Oracle, работая при этом на меньшем числе ядер. А это прямая экономия денег на лицензиях.

Для включения Jitter Smoothing и Core Boosting на сервере должна быть активирована лицензия iLO Advanced или выше. Core Boosting, кроме того, будет работать не на всех процессорах и конфигурациях сервера.

Память

Также были доработаны механизмы обеспечения отказоустойчивости памяти. В современных системах, где объем памяти исчисляется сотнями гигабайт, вероятность появления ошибок в каких-то чипах памяти очень высока. Поэтому применение инструментов для обеспечения надежности памяти (RAS) становится все более обоснованным. С поколением Gen10 HPE представила еще один такой инструмент – технологию SmartMemory Fast Fault Tolerance (FFT). Упреждающие алгоритмы в серверах HPE все время анализируют состояние чипов памяти. И, в случае появления риска для данных в какой-то области памяти в чипе, FFT назначает ей «запасные» области сравнимого объема на том же канале памяти. В результате запись и чтение данных в защищаемой области идет с контролем целостности, и пропускная способность и общий объем падают только для этой маленькой области.

В чем отличие это технологии, например, от механизма Lockstep с DDDC от Intel, который используется в процессорах Xeon E7 сейчас? В том, что с тонким контролем HPE Advanced Error Detection и Fast Fault Tolerance, мы снижаем производительность только при появлении вероятности потери данных и только для малой области памяти, в отличие от Lockstep, где производительность снижается в целом по системе, от нескольких до 50%. С FFT пропускная способность на сервер падает в среднем не более, чем на 1%. Эта технология также уникальна для HPE и не появится в серверах других производителей еще 2 года по лицензионному соглашению с Intel. В целом, применение современных технологий RAS в серверах HPE, по статистике HPE, снижает число «падений» системы в год (Annual Crash Rate) на 85%. Еще один ответ на вопрос почему память от HPE называется Smart Memory.

Другой набор инноваций по работе с памятью – это две технологии энергонезависимой оперативной памяти HPE NVDIMM и HPE Scalable Persistent Memory. Первая – это существующие уже более двух лет модули оперативной памяти, совмещенные с энергонезависимой флешкой (на том же модуле) с питанием от батарейки в сервере. Такие модули видны обычным ОС (Windows и Linux) как очень быстрое блочное устройство. А некоторым приложениям (например, Microsoft SQL Server 2016) такой модуль виден как особое устройство с побайтной адресацией (как в RAM), но с устойчивостью к отключению питания. При размещении на таких модулях, хвоста лога транзакций (Tail of transaction log) MS SQL Server’а, мы видим прирост производительности базы данных до 4 раз по сравнению с размещением хвоста лога на SSD. Новые модули HPE NVDIMM теперь имеют емкость 8 и 16 ГБ, в то время как для БД SQL размером в несколько сотен гигабайт в большинстве случаев достаточно одного модуля NVDIMM для размещения хвоста лога транзакций.

HPE Scalable Persistent Memory – это комплексные устройства, построенные на базе серверов HPE ProLiant DL380 Gen10, обычных модулей памяти DDR4 и особого механизма защиты RAM от потери питания с помощью NVMe-накопителей и резервного блока питания с внутренним ИБП в самом сервере. С этим устройством вы можете разместить в памяти до 1 ТБ данных без риска потерять их при отключении электричества, и таким образом многократно ускорить работу многих приложений. Например, во внутренних тестах с MySQL операции Checkpoint (сохранения данных БД из памяти на энергонезависимый носитель) на HPE Scalable Persistent Memory выполнялись в 27 раз быстрее, чем на HDD и в 3 раза быстрее, чем на SSD. А Restore (обратная операция – возвращение данных в память после сбоя) происходила в 13 и 5 раз быстрее соответственно. И кроме того, с такой системой практически любую БД можно превратить в in-memory, многократно повышая ее производительность.

Использование NVMe-накопителей также получило очень глубокое развитие. Теперь в каждый сервер можно установить в разы больше NVMe-накопителей (до 20 штук в DL380 Gen10, например), и в одну и ту же дисковую корзину в сервере можно устанавливать и NVMe, и SAS/SATA диски (продолжают существовать и обычные корзины без поддержки NVMe, если она вам не нужна). Плюс, появилась поддержка нового формата накопителей – uFF (micro-Form Factor), которых помещается 2 на место одного SFF-накопителя (объемы 120 и 340 ГБ, SATA). uFF-SSD могут использоваться как загрузочные или кэширующей диски для целого ряда задач, и экономят место в сервере для более емких накопителей под продуктивные данные.

Обновилась и линейка контроллеров. Теперь они быстрее (до 1,6 млн IOPS с контроллера) и могут работать одновременно в HBA и RAID-режиме (какие-то диски на контроллере в одном режиме, какие-то в другом). Полная линейка контроллеров в Gen10 на данный момент выглядит так:

iLO 5

Одна из самых мощных новинок поколения Gen10 – усовершенствованная система удаленного управления HPE iLO 5. Кроме более быстрого чипа iLO, который ускоряет операции с удаленной консолью и виртуальными накопителями, появился целый ряд новых возможностей:

Технология HPE Silicon Root of Trust – это проверка прошивки iLO на наличие в ней вредоносного кода или повреждений с помощью сверки контрольной суммы с аппаратным чипом внутри системы iLO. Когда прошивка iLO проверена, это средство управления само проверяет прошивки всех остальных компонентов сервера, включая BIOS на предмет вторжения злоумышленников или другие нарушения целостности. В случае обнаружения проблемы, iLO может автоматически или по команде восстановить конкретную прошивку в последнее рабочее состояние из защищенного репозитория прошивок, вернуть сервер к заводским настройкам или не реагировать.

Зачем эта технология? Во-первых, прошивка компонента может повредиться в процессе обновления вручную или просто из-за сбоя в микросхеме. Во-вторых, аналитики угроз ИБ с каждым годом обнаруживают все больше уязвимостей в прошивках и другом низкоуровневом коде серверов. Этот уровень практически не контролируется привычными антивирусами, поэтому и угроза там скрывается значительная.

Зачем эта технология? Во-первых, прошивка компонента может повредиться в процессе обновления вручную или просто из-за сбоя в микросхеме. Во-вторых, аналитики угроз ИБ с каждым годом обнаруживают все больше уязвимостей в прошивках и другом низкоуровневом коде серверов. Этот уровень практически не контролируется привычными антивирусами, поэтому и угроза там скрывается значительная.

Уникальность подхода HPE здесь: а) полный контроль над производством прошивок компонентов; все компоненты под брендом HPE имеют специально разработанную, либо проверенную и поставляемую только через канал HPE прошивку и, начиная с поколения Gen10, поставляются с цифровой подписью HPE. И б) только HPE разрабатывает и производит собственную систему управления iLO, от софта до микросхем, благодаря чему может встроить в нее средство проверки подписей прошивок.

Еще одно небольшое, но полезное улучшение безопасности – датчик открытия корпуса сервера, при срабатывании которого iLO может заблокировать работу сервера до выяснения причин инцидента.

Функциональное улучшение в iLO 5 – теперь средство настройки сервера, включая настройки RAID, под названием Intelligent Provisioning можно запускать прямо из консоли iLO, а не только при загрузке сервера по нажатию F10. Благодаря этому можно избежать лишних перезагрузок сервера.

Быстрее стала проходить и сама процедура загрузки при использовании UEFI-режима BIOS – в среднем загрузка в 3 раз быстрее. Изменился и стал более удобным интерфейс настройки BIOS RBSU, и запустить его тоже можно из Intelligent Provisioning (а его – из iLO).

Большой плюс для пользователей различных средств автоматизации, в том числе в многовендорных окружениях – iLO теперь поддерживает большинство инструкций Open IPMI. И к тому же HPE продолжает лидировать в наполнении стандарта управления «железом» через интерфейс REST API (читайте здесь). Теперь REST API от HPE полностью соответствует стандарту DMTF Redfish, кроме части управления RAID-контроллерами (там пока собственные REST API). Для управления через REST API есть как собственное средство, так и масса вспомогательных средств (например, для Python и PowerShell).

Еще одно новшество – на этот раз в части диагностики неисправностей. Если раньше Active Health System Log (запись «бортового самописца» сервера) можно было только выгрузить через iLO и отправить в Центр поддержки HPE для анализа, то сейчас его можно выкачать на флешку через специальный USB-порт на лицевой стороне сервера и проанализировать самостоятельно с помощью бесплатного сервиса Active Health System Viewer. Сервис показывает и предлагает решение для 25% возможных уязвимостей, а для остальных – просто значительно облегчает обращение в поддержку, сокращая время на анализ неисправности.

Новые модели HPE ProLiant Gen10

Теперь о моделях, которые уже доступны к заказу сегодня. Вот так будет выглядеть весь основной портфель серверов HPE (здесь мы не говорим о линейках Apollo, Integrity и некоторых других):

Зеленым выделены те модели, которые можно заказать сейчас. Краткий обзор моделей в картинках:

ProLiant DL360 Gen10

ProLiant DL380 Gen10

ProLiant DL560 Gen10

ProLiant BL460c Gen10

MicroServer Gen10

Кроме того, сейчас доступны к заказу новые серверы для платформы Synergy– SY480 Gen10 и SY660 Gen10, а сама платформа Synergy получила поддержку 25/50 GbE фабрики Mellanox, мощные графические опции и расширение вариантов конфигурации внутренних дисковых полок.

Плюс, существенно обновилась линейка продуктов для высокопроизводительных вычислений (НРС). Представлен новый флагман суперкомпьютерного мира – система HPE SGI 8600 с жидкостным (водяным) охлаждением. Отвечая стремительному прогрессу в мире НРС и потребностям заказчиков HPE, полностью переработана 6000-ная серия – представлена новая высокоинтегрированная система HPE Apollo 6000 Gen10 (узлы XL230k Gen10 и шасси k6000). Для решения широкого спектра задач в области искусственного интеллекта и некоторых других нагрузок, было представлено новое семейство узлов HPE Apollo 10-series, поддерживающих самые современные технологии ускорения вычислений Intel Xeon Phi 7000 и NVIDIA Tesla P100 на шине NVLink.

На этом краткий обзор завершен. Более подробно об этих новинках, и не только, можно узнать у наших специалистов.

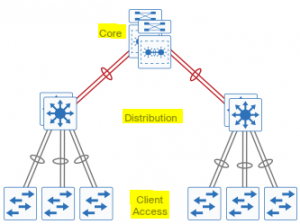

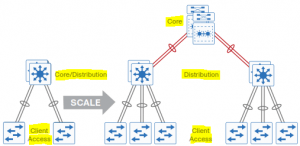

2х уровневая и 3х уровневая архитектура сети.

2х уровневая и 3х уровневая архитектура сети.

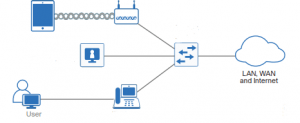

В России стали доступны к продаже коммутаторы Dell EMC Networking N1100. Эти модели расширяют линейку коммутаторов N-серии для корпоративных сетей. Являясь бюджетными Layer 2 коммутаторами, по техническим возможностям и стоимости они занимают нишу между коммутаторами X-серии и N1500.

В России стали доступны к продаже коммутаторы Dell EMC Networking N1100. Эти модели расширяют линейку коммутаторов N-серии для корпоративных сетей. Являясь бюджетными Layer 2 коммутаторами, по техническим возможностям и стоимости они занимают нишу между коммутаторами X-серии и N1500.

Зачем эта технология? Во-первых, прошивка компонента может повредиться в процессе обновления вручную или просто из-за сбоя в микросхеме. Во-вторых, аналитики угроз ИБ с каждым годом обнаруживают все больше уязвимостей в прошивках и другом низкоуровневом коде серверов. Этот уровень практически не контролируется привычными антивирусами, поэтому и угроза там скрывается значительная.

Зачем эта технология? Во-первых, прошивка компонента может повредиться в процессе обновления вручную или просто из-за сбоя в микросхеме. Во-вторых, аналитики угроз ИБ с каждым годом обнаруживают все больше уязвимостей в прошивках и другом низкоуровневом коде серверов. Этот уровень практически не контролируется привычными антивирусами, поэтому и угроза там скрывается значительная.